Key benefits of LLMs customized to your domain:

- Precision and expertise: 특정 전문 분야의 데이터 셋으로 파인 튜닝을 하거나 RAG 를 이용해서 대답하게 만든다면 훨씬 더 정확한 결과를 도출할 수 있을 것.

- Enhanced reliability: 모델의 초점을 좁히면 외부의 관련 없는 정보에 영향을 덜 받게 되어 더 일관되고 신뢰할 수 있는 출력을 제공할 수 있다.

- Safety and liability: 의료나 법률과 같은 분야에서는 잘못된 정보가 큰 문제를 일으킬 수 있기 때문에 더 신뢰가능한 대답을 만들어낼 수 있음.

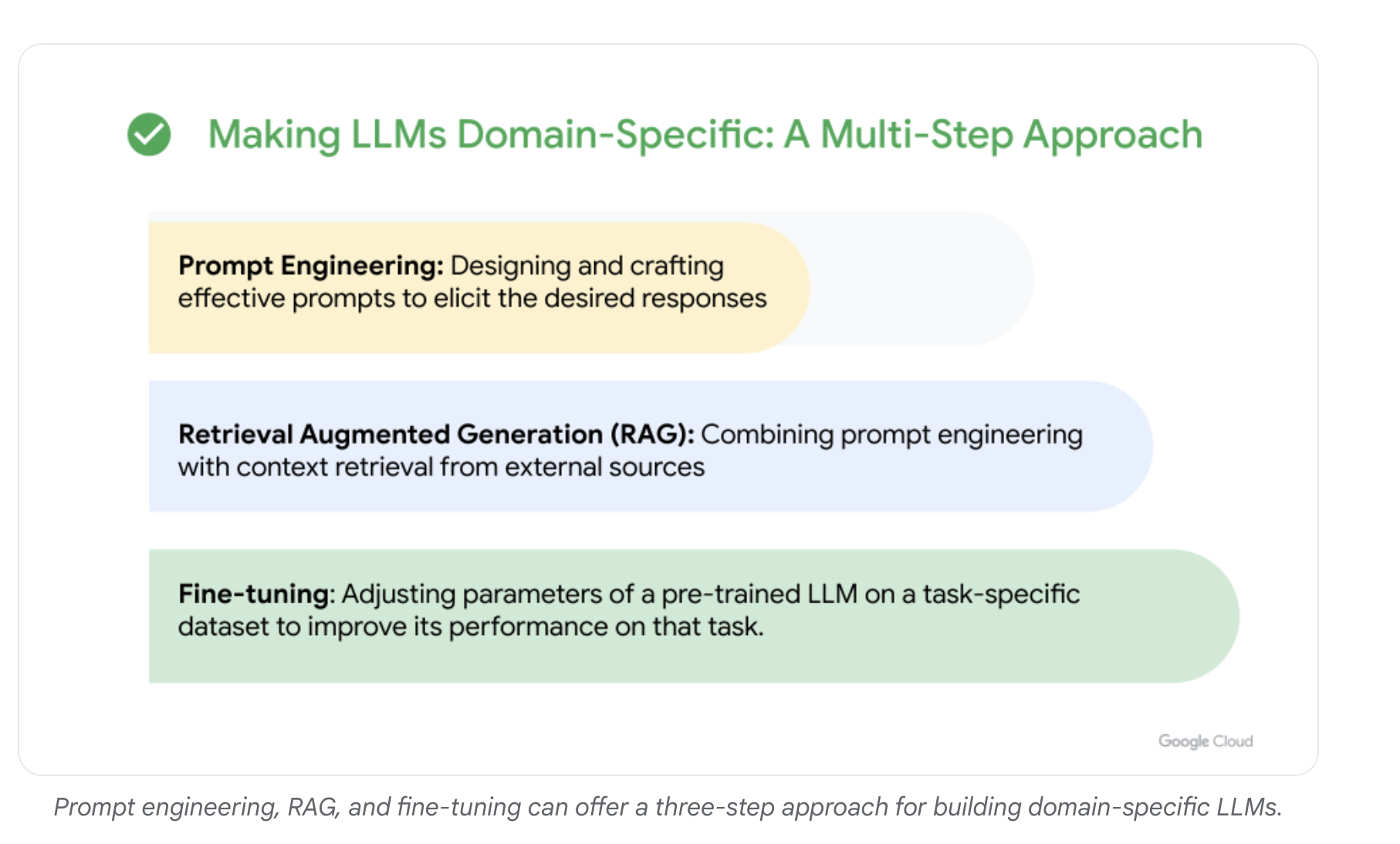

Domain-specific LLMs 를 만드는 건 결국 3가지 스텝을 이용하면 된다.

- Pretraining 은 비효율적임. BloombergGPT 도 좋은 언어 모델이 나오니까 그냥 성능이 역전된 것처럼

Best practices for training an LLM:

- Start Small: 처음에는 작게 시도하는 걸 추천한다. 성공한 후 하나씩 확장하는 걸로

- Understand scaling laws:

- 딥러닝의 스케일링 법칙은 계산 능력, 데이터셋 크기, 언어 모델의 파라미터 수 관계에서 모델의 성능을 예측하는데 사용됨.

- 이 내용은 Pretraining 에 대한 내용임.

- 법칙은 다음과 같음:

- 더 큰 모델은 유사한 데이터셋에서 훈련될 때 더 작은 모델보다 성능이 뛰어남

- 모델 크기와 데이터셋 크기 모두 LLM 성능에 중요함.

- 주어진 계산 예산 내에서, 모델의 아키텍처를 확장하는 것이 데이터셋 크기를 단순히 늘리는 것보다 성능 향상에 더 도움이 될 수 있음

- 파라미터 수와 데이터의 관계는 20:1 정도가 적절하다고 함

- Prioritize data quality:

- 현실 세계의 다양한 데이터들을 가지고 와서 반영해야한다. 모델이 편향될 수 있으니까

- Monitoring and Evaluating:

References:

'Generative AI' 카테고리의 다른 글

| LLMOps (0) | 2024.06.22 |

|---|---|

| Beyond RAG: Scaling long context (0) | 2024.06.21 |

| METAGPT: META PROGRAMMING FOR AMULTI-AGENT COLLABORATIVE FRAMEWORK (0) | 2024.06.20 |

| Building Agentic RAG with Llamaindex (0) | 2024.06.20 |

| Functions, Tools and Agents with LangChain (0) | 2024.06.12 |